Deux mois seulement après son lancement, le ChatGPT d'OpenAI a atteint 100 millions d'utilisateurs, ce qui en fait l'application grand public à la croissance la plus rapide de l'histoire, selon Reuters. Au cours des mois qui ont suivi, nous avons vu la stratégie d'IA devenir une priorité absolue pour les chefs d'entreprise : Plus de la moitié des chefs d'entreprise citent désormais l'IA générative et les LLM parmi leurs cinq principales priorités, selon notre dernière enquête Battery Ventures Cloud Logiciel Spending.

Mais l'adoption croissante de l'IA a également entraîné un examen plus approfondi et une prise de conscience des risques potentiels posés par ces systèmes. En raison de la nature "boîte noire" des modèles d'apprentissage profond, il est difficile pour les régulateurs et les consommateurs de faire confiance à ce qu'ils ne comprennent pas.

Des cas d'utilisation abusive du LLM ont déjà fait la une des journaux au cours des derniers mois. Parmi les exemples, citons l'interdiction de ChatGPT par Samsung après la fuite d' un code sensible par un employé et l'action collective intentée contre Lensa AI, un générateur d'œuvres d'art à base d'IA très populaire, au motif que l'application collectait les données biométriques des utilisateurs sans leur autorisation.

Alors que les entreprises s'empressent d'intégrer l'IA dans leurs produits, elles subissent la pression des régulateurs qui ont suivi de près l'essor de l'IA pour qu'elles le fassent dans le respect de l'éthique et de la transparence. Les décideurs politiques du monde entier ont commencé à jeter les bases d'une IA responsable et de la manière dont elle sera gérée sur les marchés. Selon nous, toute entreprise ayant une stratégie d'IA aura besoin d'une stratégie correspondante pour la gouvernance et la sécurité de l'IA - et nous voyons émerger une nouvelle pile technologique pour répondre à ce besoin.

L'état actuel de la réglementation de l'IA

Mais comment les régulateurs envisagent-ils réellement la surveillance de l'IA ? Les autorités de l'UE agissent rapidement et prennent les devants avec la loi sur l'IA, qui devrait entrer en vigueur en 2024. Les auteurs de la loi européenne sur l'IA proposent une approche variable, basée sur le risque, en imposant une "surveillance renforcée" aux systèmes d'IA "à haut risque" et seulement des "obligations de transparence limitées" aux systèmes "sans haut risque". La loi européenne sur l'IA a mis l'accent sur une documentation et une visibilité approfondies des systèmes d'IA afin de mieux comprendre leur conception, leur finalité et les stratégies d'atténuation des risques. La loi européenne sur l'IA fixe également la barre des conséquences des infractions, avec une amende de 20 millions d'euros ou de 4 % du chiffre d'affaires annuel, selon le montant le plus élevé.

En revanche, les États-Unis ne disposent pas aujourd'hui d'un cadre réglementaire fédéral pour l'IA. Malgré l'absence de contrôle fédéral, de nombreuses entreprises avec lesquelles nous nous sommes entretenus suivent le cadre volontaire de gestion des risques liés à l'IA fourni par l'Institut national des normes et de la technologie (National Institute of Standards and Technology). En l'absence de réglementation obligatoire de la part des autorités fédérales, les gouvernements locaux et étatiques interviennent pour combler le vide : La loi locale 144 de la ville de New York, en vigueur depuis juillet 2023, impose des audits de partialité par des tiers pour les systèmes d'embauche automatisés, présentant une approche plus technique que l'approche centrée sur la documentation de l'UE.

Il apparaît clairement que de nombreuses entreprises commencent à réfléchir de manière proactive aux contrôles de risque et de conformité liés à l'utilisation de l'IA, même si la réglementation fédérale américaine est encore en cours d'élaboration.

Alors, pourquoi agir maintenant ? L'IA qui n'est pas développée avec des garde-fous à l'esprit peut créer des problèmes critiques pour les entreprises bien en aval du développement initial. Outre les conséquences financières qui découleront bientôt de la réglementation, les entreprises sont confrontées à un risque commercial et de marque important en cas d'utilisation abusive de l'IA. Par exemple, l'IA qui utilise des informations personnelles identifiables (PII) ou des données biométriques nécessite une grande confiance de la part des clients, tout comme l'IA qui est utilisée dans les diagnostics médicaux ou la souscription. L'utilisation abusive de l'IA dans ces applications pourrait non seulement nuire à la marque, mais aussi avoir un impact négatif sur les consommateurs.

La pile technologique émergente en matière de conformité et de gouvernance de l'IA

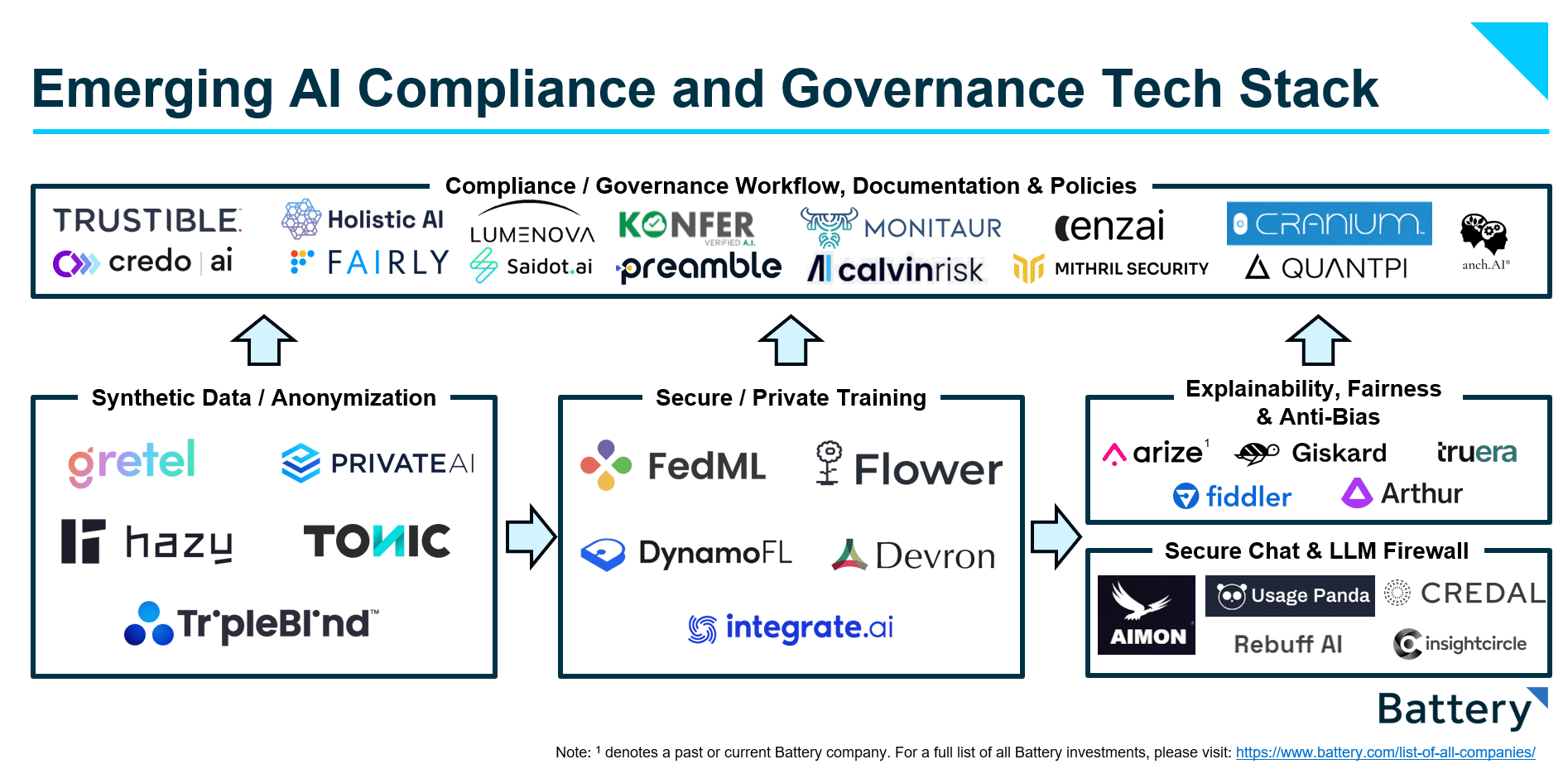

Pour faire face à ces réglementations à venir sur l'IA, nous avons vu émerger une pile technologique de conformité et de gouvernance qui permet aux entreprises de construire, de déployer et de gérer des systèmes d'IA conformes et transparents. Le processus de développement de modèles de ML est passé d'un problème purement technique à un problème impliquant diverses parties prenantes, car l'utilisation de l'IA fait l'objet d'un examen de plus en plus minutieux de la part des dirigeants, des régulateurs et des clients.

Nous considérons cette pile technologique de conformité et de gouvernance de l'IA comme deux éléments distincts, mais interdépendants :

- Machine Learning (ML) Stack-Cette technologie s'adresse aux acteurs techniques (ingénieurs ML, data scientists) qui sont responsables de la construction des modèles et de l'infrastructure nécessaires pour fournir des systèmes d'IA sûrs.

- Gouvernance / flux de travail de conformité Couche - Ce logiciel s'adresse aux acteurs non techniques (conformité, juristes, dirigeants, régulateurs) qui sont responsables de l'alignement commercial et réglementaire des systèmes d'IA.

La pile d'infrastructure d'apprentissage automatique

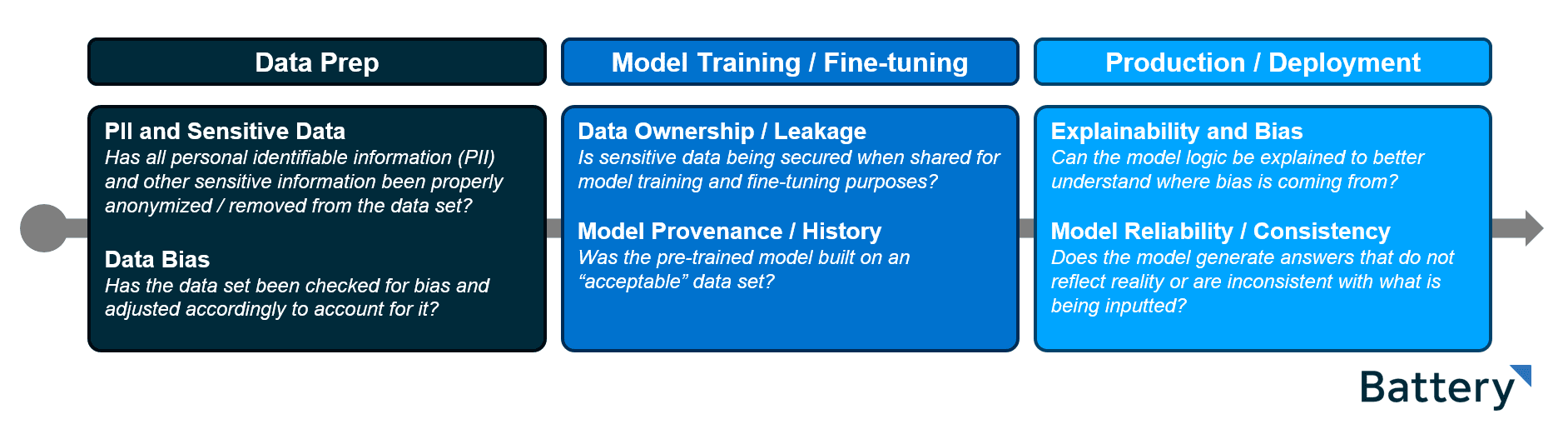

Les risques liés à l'IA sont introduits à chaque étape du cycle de vie de la ML. Cela signifie que les modèles doivent être intentionnellement conçus, formés et déployés dès le départ de manière sûre et conforme.

Chez Battery, nous décomposons le cycle de vie de la ML en trois étapes distinctes, chacune comportant son propre ensemble de risques en matière de conformité et de gouvernance :

Sur la base de notre exploration de l'espace, nous avons défini quatre catégories pour englober les outils émergents :

- Données synthétiques / Anonymisation (préparation des données) - Aider les équipes à supprimer les IIP et les données sensibles de leur ensemble de données et à l'enrichir de données synthétiques pour éliminer les biais ou remplacer le contenu expurgé.

- Formation sécurisée / privée (formation de modèles / mise au point) - Exploitation d'une variété de techniques telles que l'apprentissage fédéré et la confidentialité différentielle pour aider les entreprises à former en toute sécurité leurs propres modèles et à mettre au point des modèles préformés.

- Explicabilité, équité et lutte contre les préjugés (production/déploiement) - Évaluer et contrôler les modèles en production afin d'identifier les préjugés et les dérives, et d'apporter de la transparence dans la logique qui sous-tend les modèles.

- Chat sécurisé et pare-feu LLM (Production / Déploiement) - Construction d'une enveloppe ou d'une instance privée des déploiements LLM pour contrôler entièrement les entrées et les sorties du modèle afin de répondre aux exigences de conformité. (Il s'agit d'un espace qui, selon nous, recoupe de manière nuancée la sécurité, dont nous serons ravis de discuter si vous construisez dans cet espace).

La couche de gouvernance et de conformité

Outre les mesures de protection intégrées à la pile ML, nous prévoyons la montée en puissance d'une couche de flux de travail de conformité/gouvernance spécialement conçue pour les utilisateurs professionnels non techniques qui gèrent l'IA au sein des organisations. Ces plateformes agissent comme des systèmes d'enregistrement pour documenter, gérer et fournir une visibilité sur l'inventaire de l'IA d'une entreprise, les cas d'utilisation de l'IA et les parties prenantes du projet. Bon nombre de ces plateformes offrent des garde-fous prêts à l'emploi qui s'alignent sur les réglementations existantes et émergentes afin de garantir que les entreprises respectent les exigences en matière de documentation fixées par les autorités de réglementation.

Il s'agit de plateformes de documentation interne et de rapports sur l'utilisation de l'IA, qui permettent de combler le fossé entre les équipes techniques qui construisent les systèmes d'IA et les équipes commerciales non techniques qui les gèrent. En traduisant les métriques et les artefacts des modèles ascendants en rapports simples et compréhensibles pour les parties prenantes non techniques, les plateformes de gouvernance et de conformité renforceront la transparence et l'adhésion à l'intérieur et à l'extérieur de leurs organisations.

Conclusion & Opportunité de marché

Dans l'ensemble, nous pensons que la pile logicielle de gouvernance de l'IA que nous avons décrite représente une catégorie logicielle émergente passionnante et une grande opportunité de marché. La confiance et la transparence sont essentielles. Nous pensons que les entreprises continueront à adopter Logiciel qui les aide à s'assurer que leur IA est sûre, conforme et transparente. Nous sommes impatients de voir ce marché se développer et nous restons à l'écoute. Si vous construisez ou investissez dans la gouvernance de l'IA, n'hésitez pas à nous contacter !

*Dénote une entreprise de Battery Portefeuille. Pour une liste complète de tous les investissements de Battery, veuillez cliquer ici.

Les informations contenues dans le présent document sont basées uniquement sur les opinions de Dharmesh Thakker, Dallin Bills, Jason Mendel, Patrick Hsu et Adam Piasecki et rien ne doit être interprété comme un conseil en matière d'investissements. Ce matériel est fourni à titre d'information et ne constitue en aucun cas un conseil juridique, fiscal ou d'investissement, ni une offre de vente ou une sollicitation d'une offre d'achat d'une participation dans un fonds ou un véhicule d'investissement géré par Battery Ventures ou toute autre entité de Battery.

Les informations et les données sont en date de la publication, sauf indication contraire. Le contenu obtenu de sources tierces, bien que considéré comme fiable, n'a pas été vérifié de manière indépendante quant à son exactitude ou son exhaustivité et ne peut être garanti. Battery Ventures n'a aucune obligation de mettre à jour, de modifier ou d'amender le contenu de ce post ni d'avertir ses lecteurs dans le cas où toute information, opinion, projection, prévision ou estimation incluse, changerait ou deviendrait ultérieurement inexacte.

Les informations ci-dessus peuvent contenir des projections ou d'autres déclarations prévisionnelles concernant des événements ou des attentes futurs. Les prédictions, opinions et autres informations discutées dans cette vidéo sont susceptibles d'être modifiées en permanence et sans préavis d'aucune sorte et peuvent ne plus être pertinentes après la date indiquée. Battery Ventures n'assume aucune obligation et ne s'engage pas à mettre à jour les déclarations prospectives.

Un bulletin d'information mensuel pour partager de nouvelles idées, des aperçus et des introductions pour aider les entrepreneurs à développer leurs entreprises.